Mục Lục

- 1 1. File robots.txt là gì trong hoạt động SEO?

- 2 2. Tầm quan trọng của của file robots.txt đối với SEO

- 3 3. Các lệnh quan trọng trong file robots.txt

- 4 4. Những điểm hạn chế của file robots.txt

- 5 5. Một số quy tắc khi viết các file robots.txt bạn nên biết

- 6 6. Mẫu file robot.txt bạn nên biết

- 7 7.1 Hướng dẫn chi tiết cách tạo file robot.txt

- 8 8. Một số câu hỏi liên quan về file robot.txt bạn nên biết

Bạn đã từng thắc mắc về cách thức hoạt động của Googlebot – “con nhện” quyền lực trong việc thu thập thông tin cho công cụ tìm kiếm khổng lồ Google? Hay bạn mong muốn website của mình được Google ưu ái, gia tăng thứ hạng tìm kiếm và thu hút lượng truy cập khổng lồ? Nếu vậy, file robots.txt chính là điều mà bạn đang tìm hiểu. Vậy robots.txt là gì? Tìm hiểu chi tiết về cách hoạt động của file robots.txt ngay qua bài viết này!

1. File robots.txt là gì trong hoạt động SEO?

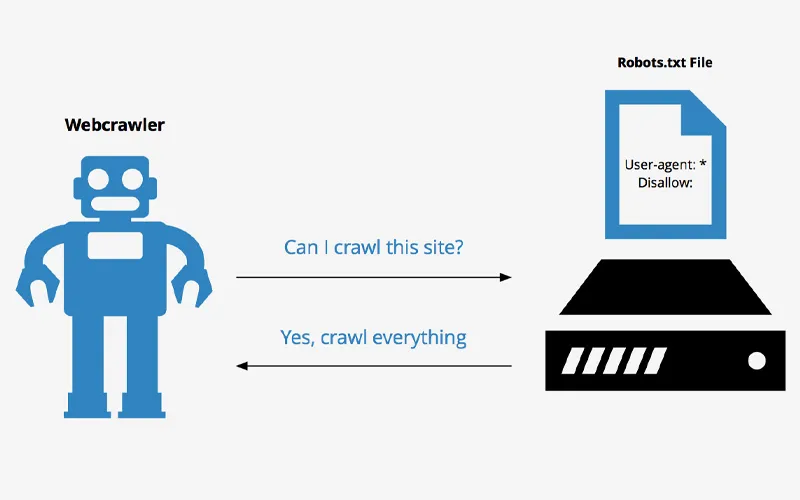

File robots.txt là một tập tin văn bản đơn giản được đặt tại thư mục gốc của website, đóng vai trò như “bản đồ hướng dẫn” cho các “con nhện” thu thập dữ liệu (hay còn gọi là bot) của Google. Nó cung cấp thông tin chi tiết về những phần nội dung mà Googlebot được phép truy cập và thu thập thông tin để lập chỉ mục cho website của bạn.

Nói cách khác, file robots.txt giúp bạn “điều khiển” Googlebot, cho phép bạn có thể thực hiện một số điều sau:

- Xác định các trang web mà bạn muốn Googlebot thu thập: Bạn có thể sử dụng lệnh “Allow” để cho phép Googlebot truy cập vào các trang và thư mục cụ thể.

- Chặn các trang web mà bạn không muốn Googlebot thu thập: Lệnh “Disallow” được sử dụng để ngăn chặn Googlebot truy cập vào các trang và thư mục nhất định, ví dụ như trang quản trị, trang đăng nhập hoặc nội dung nhạy cảm.

- Cung cấp thông tin về Sitemap: Sitemap là tập tin XML liệt kê tất cả các trang web quan trọng trên website của bạn. File robots.txt có thể được sử dụng để thông báo cho Googlebot vị trí của Sitemap, giúp Googlebot dễ dàng thu thập thông tin đầy đủ và chính xác hơn.

Xem thêm: Audit website là gì?

2. Tầm quan trọng của của file robots.txt đối với SEO

File robots.txt tưởng chừng đơn giản nhưng lại đóng vai trò vô cùng quan trọng trong việc tối ưu hóa SEO, góp phần đưa website của bạn lên vị trí “ngôi vương” trên bảng xếp hạng tìm kiếm. Vậy tầm quan trọng của file robots.txt đối với SEO là gì?

2.1 Định hướng cho Googlebot vào website

File robots.txt như một “bản đồ thông minh” dẫn dắt Googlebot – “con nhện” quyền lực của Google – đi đúng hướng và thu thập thông tin hiệu quả. Nó cho Googlebot biết những trang web nào được phép truy cập để lập chỉ mục, những trang nào cần được “bỏ qua” để tối ưu hóa quá trình thu thập dữ liệu.

2.2 Cải thiện hiệu quả của việc Crawl Budget

Crawl Budget là số lượng trang web mà Googlebot có thể thu thập trong một khoảng thời gian nhất định. Việc sử dụng file robots.txt hợp lý giúp Googlebot tập trung vào những trang web quan trọng, có giá trị cao, thay vì lãng phí thời gian và tài nguyên cho những trang không cần thiết.

2.3 Tránh lập chỉ mục các nội dung trùng lặp trên website

Nội dung trùng lặp có thể ảnh hưởng tiêu cực đến thứ hạng website của bạn trên Google. File robots.txt giúp bạn chặn các trang web có nội dung trùng lặp, đảm bảo Googlebot chỉ thu thập thông tin duy nhất và chất lượng nhất từ website của bạn.

Xem thêm: Những công cụ kiểm tra thứ hạng từ khóa giúp bạn theo dõi tiến trình dự án SEO

2.4 Bảo vệ những nội dung nhạy cảm trên website của bạn

Bạn có những nội dung nhạy cảm hoặc chưa hoàn thiện mà không muốn hiển thị trên kết quả tìm kiếm? File robots.txt là giải pháp hoàn hảo để “giấu kín” những nội dung này, bảo vệ thông tin và hình ảnh thương hiệu của bạn.

2.5 Ngăn chặn các vấn đề về hoạt động SEO

Sử dụng file robots.txt không đúng cách có thể dẫn đến những hậu quả nghiêm trọng cho SEO, như website bị deindex, thứ hạng tìm kiếm tụt dốc, v.v. Việc nắm vững cách sử dụng file robots.txt giúp bạn tránh được những “bẫy SEO” nguy hiểm này.

Xem thêm: Các công cụ check trùng lặp nội dung giúp bạn phát hiện tình trạng duplicate

3. Các lệnh quan trọng trong file robots.txt

File robots.txt – tưởng chừng đơn giản nhưng ẩn chứa sức mạnh to lớn, đóng vai trò như “bản hướng dẫn” chi tiết cho Googlebot trong việc thu thập dữ liệu website của bạn. Để “điều khiển” Googlebot hiệu quả, bạn cần nắm vững các lệnh quan trọng trong file robots.txt.

3.1 Lệnh User-agent trong file robot.txt

User-agent xác định loại bot nào được phép truy cập vào website của bạn. Lệnh này thường được sử dụng để phân biệt Googlebot với các bot khác như Bingbot, BaiduBot, v.v.

VD: User-agent: *

Lệnh này cho phép tất cả các bot truy cập vào website.

VD: User-agent: Googlebot

Lệnh này chỉ cho phép Googlebot truy cập vào website.

3.2 Lệnh Disallow URL của website trong file robot.txt

Lệnh Disallow được sử dụng để chặn các bot truy cập vào các thư mục hoặc trang web cụ thể. Ví dụ: Disallow: /wp-admin/

Lệnh này chặn Googlebot truy cập vào thư mục wp-admin (nơi quản trị website WordPress).

3.3 Lệnh Allow trong file robot.txt

Lệnh Allow được sử dụng để cho phép các bot truy cập vào các thư mục hoặc trang web cụ thể, ngay cả khi chúng bị chặn bởi lệnh Disallow.

Ví dụ:

Disallow: /wp-includes/

Allow: /wp-includes/images/

Lệnh này chặn Googlebot truy cập vào thư mục wp-includes, nhưng cho phép truy cập vào thư mục con images/ bên trong thư mục wp-includes.

3.4 Lệnh Sitemap trong file robot.txt

Lệnh Sitemap được sử dụng để thông báo cho Googlebot vị trí của Sitemap – tập tin XML liệt kê tất cả các trang web quan trọng trên website của bạn.

Ví dụ: Sitemap: https://example.com/sitemap.xml

Lệnh này giúp Googlebot dễ dàng thu thập thông tin đầy đủ và chính xác hơn về website của bạn.

4. Những điểm hạn chế của file robots.txt

File robots.txt – công cụ đắc lực trong chiến lược SEO, tuy nhiên, nó cũng tồn tại một số hạn chế nhất định mà bạn cần lưu ý để tránh mắc phải những sai lầm tai hại. Hãy cùng “giải mã” những điểm yếu tiềm ẩn của file robot.txt này nhé!

4.1 Không hoàn toàn “tự chủ”

Mặc dù file robots.txt có thể chặn các bot truy cập vào website, nhưng điều này không đảm bảo rằng các bot sẽ hoàn toàn tuân thủ. Một số bot “cứng đầu” có thể phớt lờ file robots.txt và vẫn cố gắng truy cập vào website của bạn.

4.2 Dễ mắc lỗi

Sử dụng file robots.txt sai cách có thể dẫn đến những hậu quả nghiêm trọng cho SEO, như website bị deindex, thứ hạng tìm kiếm tụt dốc, v.v. Việc viết sai cú pháp hoặc sử dụng các lệnh không chính xác có thể khiến Googlebot hiểu lầm và ảnh hưởng tiêu cực đến website của bạn.

4.3 Không bảo vệ nội dung đã được lập chỉ mục

File robots.txt chỉ có thể ngăn chặn các bot truy cập vào những trang web mới, nó không có khả năng “gỡ bỏ” những trang đã được lập chỉ mục trước đó. Do đó, nếu bạn muốn xóa một trang web khỏi kết quả tìm kiếm, bạn cần sử dụng các công cụ khác như Google Search Console.

4.4 Phụ thuộc vào Googlebot

Hiệu quả của file robots.txt phụ thuộc hoàn toàn vào Googlebot. Googlebot có thể thay đổi cách thức hoạt động theo thời gian, do đó, bạn cần thường xuyên cập nhật file robots.txt để đảm bảo nó hoạt động hiệu quả.

4.5 Không thể kiểm soát tất cả các bot

Có rất nhiều loại bot khác nhau trên internet, và không phải tất cả các bot đều tuân thủ theo file robots.txt. Do đó, bạn có thể gặp rủi ro khi sử dụng file robots.txt để chặn tất cả các bot truy cập vào website của mình.

5. Một số quy tắc khi viết các file robots.txt bạn nên biết

Để “điều khiển” Googlebot hiệu quả và chinh phục SEO dễ dàng, hãy ghi nhớ những quy tắc vàng sau khi tạo file robots.txt:

5.1 Sử dụng cú pháp viết tệp chính xác

- Mỗi dòng trong file robots.txt chỉ chứa một lệnh.

- Lệnh Disallow và Allow không phân biệt chữ hoa chữ thường.

- Sử dụng dấu * để thay thế cho bất kỳ ký tự nào trong lệnh Disallow.

- Tránh sử dụng các ký tự đặc biệt hoặc dấu cách trong tên thư mục hoặc trang web.

5.2 Xác định User-agent

- Sử dụng lệnh User-agent để phân biệt Googlebot với các bot khác.

- Bạn có thể sử dụng nhiều lệnh User-agent trong file robots.txt để định cấu hình cho từng loại bot cụ thể.

5.3 Sử dụng lệnh Disallow hợp lý

- Chặn các thư mục hoặc trang web không cần thiết để Googlebot tập trung vào nội dung quan trọng.

- Tránh chặn các thư mục chứa CSS, JavaScript hoặc hình ảnh vì điều này có thể ảnh hưởng đến hiển thị website.

5.4 Sử dụng lệnh Allow khi cần thiết

- Sử dụng lệnh Allow để cho phép Googlebot truy cập vào các thư mục hoặc trang web bị chặn bởi lệnh Disallow.

- Ví dụ: bạn có thể sử dụng lệnh Allow để cho phép Googlebot truy cập vào thư mục con images/ bên trong thư mục wp-includes/ bị chặn bởi lệnh Disallow.

5.5 Sử dụng lệnh Sitemap

- Sử dụng lệnh Sitemap để thông báo cho Googlebot vị trí của Sitemap – tập tin XML liệt kê tất cả các trang web quan trọng trên website của bạn.

- Điều này giúp Googlebot dễ dàng thu thập thông tin đầy đủ và chính xác hơn về website của bạn.

6. Mẫu file robot.txt bạn nên biết

Dưới đây là mẫu file robots.txt chuẩn cho website WordPress mà bạn có thể tham khảo và điều chỉnh cho phù hợp với nhu cầu của mình:

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Disallow: /wp-includes/

Allow: /wp-includes/images/

Disallow: /wp-content/plugins/

Disallow: /wp-content/themes/

Sitemap: https://example.com/sitemap.xml

User-agent: Googlebot

Disallow: /wp-content/uploads/wp-editor/

7.1 Hướng dẫn chi tiết cách tạo file robot.txt

7.2 Bước 1: Mở ra Notepad hoặc TextEdit để viết file robot txt

- Đối với Windows: Mở ứng dụng Notepad bằng cách click vào Start Menu, tìm kiếm “Notepad” và click vào biểu tượng ứng dụng.

- Đối với Mac: Mở ứng dụng TextEdit bằng cách truy cập Applications > TextEdit.

7.3 Bước 2: Viết nội dung cho file robots.txt

- Dòng 1: Thêm dòng User-agent: * để cho phép tất cả các bot truy cập vào website của bạn.

- Dòng 2: Thêm dòng Disallow: /wp-admin/ để chặn tất cả các bot truy cập vào thư mục wp-admin (nơi quản trị website WordPress).

- Dòng 3: Thêm dòng Allow: /wp-admin/admin-ajax.php để cho phép Googlebot truy cập vào tập tin admin-ajax.php trong thư mục wp-admin, tập tin này cần thiết cho một số chức năng của WordPress.

- Dòng 4: Thêm dòng Disallow: /wp-includes/ để chặn tất cả các bot truy cập vào thư mục wp-includes, thư mục này chứa các tập tin cốt lõi của WordPress.

- Dòng 5: Thêm dòng Allow: /wp-includes/images/ để cho phép Googlebot truy cập vào thư mục con images/ bên trong thư mục wp-includes, thư mục này chứa các hình ảnh mặc định của WordPress.

- Dòng 6: Thêm dòng Disallow: /wp-content/plugins/ để chặn tất cả các bot truy cập vào thư mục plugins, thư mục này chứa các plugin WordPress.

- Dòng 7: Thêm dòng Disallow: /wp-content/themes/ để chặn tất cả các bot truy cập vào thư mục themes, thư mục này chứa các theme WordPress.

7.4 Bước 3: Lưu file robots.txt

- Đối với Windows: Click vào File > Save As.

- Đối với Mac: Click vào File > Save.

- Đặt tên file là robots.txt và lưu file vào thư mục gốc của website bạn (thường là thư mục public_html).

7.5 Bước 4: Upload file robots.txt lên hosting

- Sử dụng phần mềm FTP để kết nối với hosting của bạn.

- Upload file robots.txt vào thư mục gốc của website bạn.

8. Một số câu hỏi liên quan về file robot.txt bạn nên biết

Dưới đây là một số câu hỏi liên quan về file robot.txt mà bạn có thể tham khảo:

8.1 File robot.txt có áp dụng cho cả tên miền chính và phụ không?

File robots.txt không có thể áp dụng cho cả tên miền chính (https://example.com/) và phụ (https://m.example.com/). Nếu bạn muốn chặn thu thập dữ liệu của tên miền phụ thì cần tạo một tệp robot.txt riêng cho tên miền phụ đó.

8.2 File robots.txt nằm ở đâu trên website?

File robots.txt nằm ở thư mục gốc của website của bạn. Thư mục gốc thường được ký hiệu là /, là thư mục đầu tiên khi bạn truy cập vào website qua FTP hoặc giao diện quản trị file hosting.

Sử dụng file robots.txt một cách hiệu quả đòi hỏi sự hiểu biết nhất định về hoạt động của Googlebot và các nguyên tắc SEO. Tuy nhiên, với những thông tin cơ bản được chia sẻ trong bài viết này của DK Tech, hy vọng bạn đã giải đáp được thắc mắc robots.txt là gì, và có cái nhìn rõ ràng hơn về file robots.txt và vai trò quan trọng của nó trong việc tối ưu hóa website cho công cụ tìm kiếm.

Xem thêm: Dịch vụ thiết kế website theo yêu cầu tại DK Tech